Veza veštačke inteligencije i kriminala - Dipfejk kao jedna od štetnosti AI i novi oblik nasilja nad ženama

Izvor: eKapija

Četvrtak, 14.03.2024.

Četvrtak, 14.03.2024.

11:25

11:25

Četvrtak, 14.03.2024.

Četvrtak, 14.03.2024.

11:25

11:25

Platforme za razmenu video-klipova i fotografija doprinose razvoju ove kriminalne aktivnosti (Foto: Pixabay/Claudio_Scott)

Roboti koji pomažu u hirurškim intervencijama, roboti kopirajteri, novi lek za spinalnu mišićnu atrofiju zahvaljujući AI, nove pesme Tošeta Proeskog nastale opet pomoću AI, samo su neke od poslednjih vesti koje govore o tome kako nam AI (artificial intelligence) sve više unapređuje život, ili će to tek uraditi. Na nivou država donose se zakoni i formiraju tela koja će se baviti strategijama razvoja u ovoj oblasti. Recimo, Evropski parlament usvojio je Zakon o veštačkoj inteligenciji, a ove godine bi i Srbija trebalo da dobije novi zakon o informacionoj bezbednosti i strategiju razvoja veštačke inteligencije, nakon čega bi, kako je najavljeno pre neki dan, trebalo da dobije i agenciju za informacionu bezbednost.

Svi ovi koraci, nadamo se, ići će u korist borbe protiv one uloge koju AI takođe ima, a koja nije nimalo humana ni moralna kao primeri sa početka teksta i koju je veštačka inteligencija dobila u nekim kriminalnim krugovima.

Iako se pojave o kojima je reč još uvek dešavaju "tamo negde", verovatno je pitanje trenutka kada će i to stići kod nas. Reč je, naime, o dipfejku (deepfake), odnosno kreiranju lažnih video-klipova, čiju je pojavu, kako navodi sagovornik eKapije, Darko Dimovski, profesor Pravnog fakulteta u Nišu, upravo omogućio razvoj savremenih tehnologija, odnosno veštačka inteligencija.

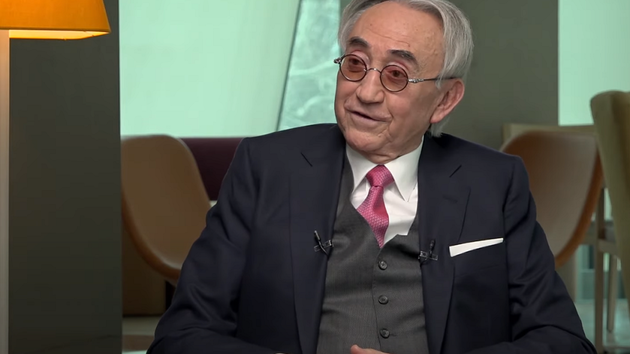

- Kontinuirani razvoj savremenih tehnologija je omogućio stvaranje tehnika za kreiranje video-zapisa i drugog sadržaja čija je suština u lažnom predstavljanju ljudi i događaja. Naime, tri napretka u razvoju tehnologije omogućila su stvaranje dipfejka. Prvi napredak ogledao se u tome da su stručnjaci za kompjuterski vid razvili algoritam čija se suština odnosi na mogućnost automatskog mapiranja orijenta lica na slikama, poput položaja obrva i nosa, što rezultira stvaranjem tehnike prepoznavanja lica. Dostupnost velikih količina audio-vizuelnih podataka usled uspona i široke upotrebe interneta, naročito platformi za razmenu video-klipova i fotogafija, predstavlja drugi napredak. Povećanje kapaciteta forenzike slike, što je treći ključni napredak u stvaranju dipfejka, učinio je mogućim automatsko otkrivanje falsifikata. Na osnovu navedenog stvoreni su uslovi da veštačka inteligencija može da uči tako što otkriva obrasce u velikim skupovima podataka - navodi prof. Dimovski samo neke od detalja kojima se bavio istražujući nove oblike kriminala za svoju monografiju "Kriminalna fenomenologija", koju je izdao Pravni fakultet Univerziteta u Nišu.

Suština dipfejk tehnologije ogleda se u korišćenju veštačke inteligencije za prepoznavanje i zamenu lica na fotografijama i video-zapisima. Drugim rečima, kako ističe naš sagovornik, dipfejk na početku analizira fotografije ili video-zapise određene osobe, nakon čega veštačka inteligencija kreira odgovarajući algoritam za manipulisanje tim licem, pri čemu dolazi do mapiranja lica u video-zapis. A na taj način - kreiranjem lažnih video-klipova, proširene su mogućnosti za razne kriminalne aktivnosti, a pogotovo, kako kaže prof. Dimovski, za viktimizaciju žena.

Trenutno je za jedan lažni video potrebno na hiljade fotografija, ali procene su da će u budućnosti biti potrebno svega nekoliko (Foto: Anton Violin/shutterstock.com)

- Prema procenama stručnjaka, broj dipfejk snimaka eksponencijalno raste, udvostručujući se svakih šest meseci, što znatno povećava obim viktimizacije žena. Na internetu kruži oko 85.000 slučajeva dipfejka, pri čemu 90% prikazuje pornografiju ženama bez njihovog pristanka. Ukoliko bismo napravili uvid u kreatore ovih lažnih video-klipova, videli bismo da njihovi tvorci potiču iz država širom sveta. Interesantno je istaći da od onih počinioca koji navode svoj pol, svi osim jednog su muškog pola, što nam ukazuje da dipfejk predstavlja novu formu nasilja nad osobama ženskog pola - dodaje prof. Dimovski.

Kao neke od primera upotrebe dipfejka u svetu slavnih žena, naš sagovornik je naveo slučaj američke glumice Skarlet Johanson, kojoj je lice utisnuto u porno snimak, pa zatim Tejlor Svift, pa britanske spisateljice Helen. Ova spisateljica je, kako navodi prof. Dimovski, oktobra 2020. godine dobila upozorenje da je na jednom porno sajtu pušteno više lažnih video-klipova na kojima se ona, navodno, upušta u ekstremne akte seksualnog nasilja.

Za jedan lažni video-snimak, prema rečima našeg sagovornika, neophodno je da se prikupi na hiljade fotografija, a potom i da se one izrežu tako da prikazuju samo lice. Za to su potrebne fotografije iz što više različitih uglova i osvetljenja, kako bi se kodirale i prenele različite nijanse lica. S obzirom na to da su potrebni što veći skupovi podataka, više je nego jasno da su lažni video-klipovi uglavnom usmereni prema javnim ličnostima.

- Nemoguće je napraviti sintetički video neke osobe ukoliko nemate sate njenih video-snimaka. Međutim, ove pojave se ne dešavaju samo slavnima. Kao ilustraciju, navešćemo slučaj iz stvarnog života o nasilju nad ženom upotrebom dipfejka. Istraživačka novinarka i kolumnistkinja Posta, Rana Ajub (Rana Aiiub) iz Indije bila je 2018. godine žrtva dipfejka na kojem je prikazana na lažnom porno snimku. Ovaj lažni snimak završio je na telefonima miliona njenih sugrađana, nakon čega je Rana završila i u bolnici. Bitno je napomenuti naedakvatnu i neblagovremenu reakciju državnih organa u zaštiti ove novinarke. Do njihove intervencije došlo je tek nakon poziva specijalnih izvestilaca Ujedinjenih nacija - upozorava prof. Dimovski, navodeći da će u budućnosti za kreiranje ovakvih klipova verovatno biti potrebno i svega nekoliko fotografija.

On smatra da na nekoliko poznatih primera ne treba stvoriti lažno uverenje da tek poneka žena postane žrtva dipfejka.

- Naime, u jednom istraživanju je Henri Ajder (Henry Ajder) 2020. godine otkrio Telegram kanal preko kojeg su korisnici plaćali 1,25 USD za generisanje golih slika više od 680.000 žena, uglavnom u istočnoj Evropi i Rusiji, bez njihovog znanja ili saglasnosti - ističe prof. Dimovski.

Ipak, realnost pokazuje da nisu samo žene ugrožene ovom nemoralnom primenom savremenih tehnologija.

- Na primer, Univerzitet u Vašingtonu je 2017. godine napravio sintetički video-snimak sa bivšim predsednikom SAD, Barakom Obamom. Već naredne godine stvoren je sintetički video o tome kako, tada aktuelni američki predsednik, Donald Tramp ohrabruje Vladu Belgije da preduzme odlučne korake u borbi za klimatske promene - dodaje prof. Dimovski.

Paralela između posledica dipfejka i osvetničke pornografije (Foto: KC Slagle/shutterstock.com)

Govoreći o potencijalu dipfejka u pogledu viktimizacije žena, naš sagovornik iznosi i neke od podataka u vezi sa osvetničkom pornografijom jer se po pitanju posledica između ove dve pojave pravi paralela. Zbog lažnih snimaka će, dodaje on, kao i kad je u pitanju osvetnička pornografija, žrtva da se preseli u drugi kraj, promeni posao, izgubi status u društvu ili se psihički razboli, ili u najgorem slučaju, pomisli i na samoubistvo.

- Prema dostupnim podacima, 6% žena mlađih od 30 godina u SAD bilo je žrtva osvetničke pornografije. U drugim državama, poput Škotske, tokom 2018. godine prijavljen je 421 slučaj pornografije iz osvete. Znajući ove podatke možemo uvideti da će dipfejk stvoriti još veće probleme, naročito zato što je samo nekolicina država prepoznala rizik od zloupotrebe dipfejka, te donela odgovarajući normativni okvir - završava prof. Dimovski.

Prema njegovim rečima, postoje dva oblika dipfejka.

- Prvi oblik, poznat pod nazivom: Generativne adversarne mreže (Generative Adversarial Networks - GAN), jeste algoritam mašinskog učenja koji na osnovu postojećih slika stvara nove slike uporedivog nivoa kvaliteta, odnosno na osnovu prethodnih podataka stvara nešto novo. Njegov način funkcionisanja se ogleda u tome da se dve neuronske mreže, generator i diskriminator, postavljaju jedna nasuprot drugoj, pri čemu generator stvara novu sliku, a diskriminator određeje da li je reč o pravoj ili lažnoj slici. Generator i diskriminator su u stalnoj interakciji na taj način da generator uči da stvori sliku toliko vernu originalu da je diskriminator prihvati kao stvarnu, dok diskriminator uči kako da prepozna lažnu sliku, a time da ne bude prevaren.

Drugi oblik se naziva autokoderi (Autoencoders). On radi tako što izvlači informacije o crtama lica iz slika i koristi ih za pravljenje slika sa drugačijim izrazom lica. Iako opšta javnost smatra da se za pravljenje dipfejk najčešće koristi GAN, autokoder se zapravo znatno više koristi prilikom kreiranja sintetičkih slika i video-klipova. Naime, autokoder je posebna vrsta algoritma dipfejka koji obavlja dva zadatka. Prvi zadatak se ogleda u kodiranju ulazne slike u mali skup numeričkih vrednosti, pri čemu se kodiranje vrši kroz niz slojeva koji počinju sa mnogo promenljivih i postepeno postaju sve manji dok dođu do sloja "uskog grlaˮ ("bottleneck" layer), u kome se nalazi ciljni broj promenljivih. Drugi zadatak odnosi se na dekodiranje podataka u sloju uskog grla i ponovnom stvaranju originalne slike. Drugim rečima, autokoderi isporučuju niz slika, pri čemu je težnja da se parametri podese tako da izlazna slika bude što sličnija ulaznoj - navodi prof. Dimovski.

Danijela Stanimirović-Gavrilov

Firme:

Pravni fakultet Niš

Pravni fakultet Niš

Tagovi:

Darko Dimovski

Univerzitet u Vašingtonu

Evropski parlament

Skarlet Johanson

Tejlor Svift

Barak Obama

Donald Tramp

Rana Ajub

Rana Aiiub

Henri Ajder

Henry Ajder

Kriminalna fenomenologija

deepfake

dipfejk

Toše Proeski

veštačka inteligencija

AI

artificial intelligence

Zakon o veštačkoj inteligenciji

Agencija za informacionu bezbednost

savremene tehnologije

video klipovi

fotografije

platforme za razmenu fotografija

falsifikati

algoritmi

viktimizacija žena

nasilje nad ženama

osvetnička pornografija

normativni okvir

Komentari

Vaš komentar

Naš izbor

Rubrike za dalje čitanje

Potpuna informacija je dostupna samo komercijalnim korisnicima-pretplatnicima i neophodno je da se ulogujete.

Pratite na našem portalu vesti, tendere, grantove, pravnu regulativu i izveštaje.

Registracija na eKapiji vam omogućava pristup potpunim informacijama i dnevnom biltenu

Naš dnevni ekonomski bilten će stizati na vašu mejl adresu krajem svakog radnog dana. Bilteni su personalizovani prema interesovanjima svakog korisnika zasebno,

uz konsultacije sa našim ekspertima.

Serbia Edition

Serbia Edition Serbische Ausgabe

Serbische Ausgabe Izdanje BiH

Izdanje BiH Izdanje Crna Gora

Izdanje Crna Gora

Vesti

Vesti